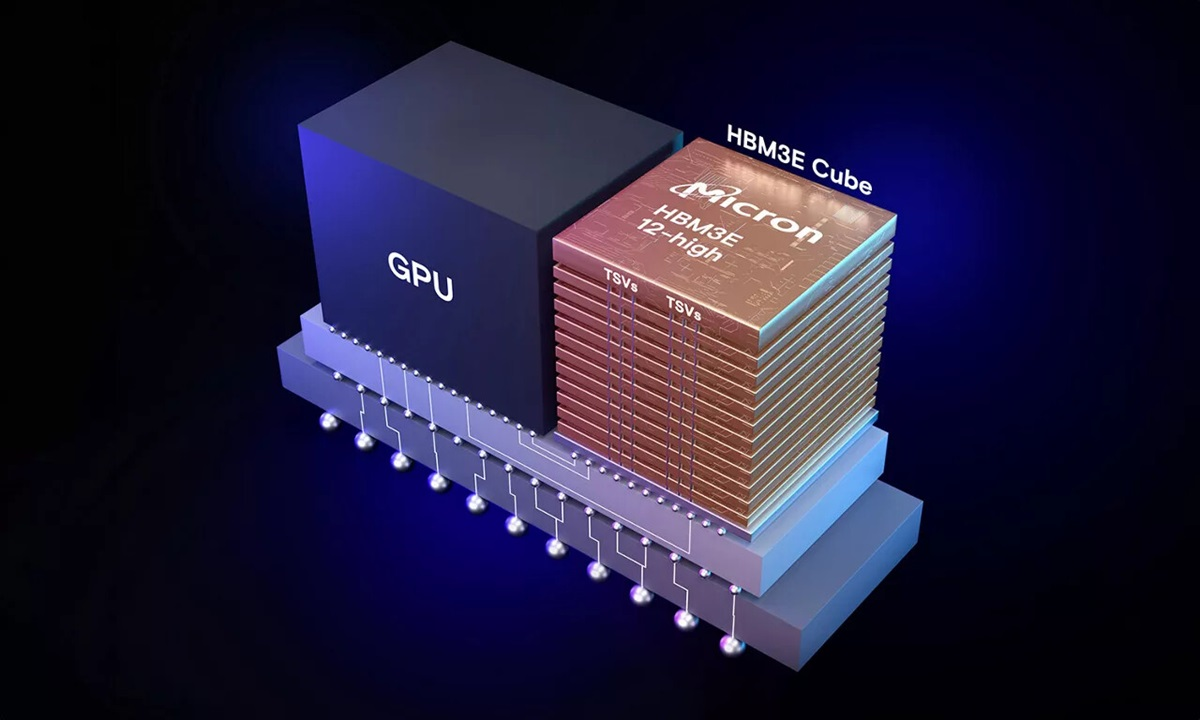

美光宣布,推出12层垂直堆叠的HBM3E,拥有36GB容量,面向用于人工智能(AI)和高性能计算(HPC)工作负载,比如英伟达H200与B100/B200 GPU产品。美光表示,相比于年初量产的8层垂直堆叠的HBM3E,在给定的堆栈高度下,新产品无论堆叠层数还是容量都增加了50%,满足了更大的AI模型运行的需求,避免了多处理器运行带来的延迟问题。

美光提供的HBM3E产品拥有16个独立的高频数据通道,采用了1β(1-beta)工艺打造,封装规格为11mm x 11mm,堆叠12层的24Gb裸片,提供了36GB容量,带宽超过1.2TB/s、引脚速度超过9.2GB/s。美光将硅通孔(TSV)增加了一倍,封装互连缩小了25%,功耗比起竞品降低了30%。美光凭借先进CMOS技术创新,结合先进的封装技术,提供了改善热阻抗的结构解决方案,有助于改善立方体的整体散热表现,加上大幅度降低的功耗,为客户提供了功耗更低、散热效率更高的HBM3E产品。

台积电生态系统和联盟管理负责人Dan Kochpatcharin表示:“台积电和美光一直保持着长期的战略合作伙伴关系。作为OIP生态系统的一部分,我们密切合作,让美光基于HBM3E的系统和CoWoS封装设计能够支持客户的人工智能创新。”

目前美光正在向主要行业合作伙伴运送量产型的12层垂直堆叠HBM3E,用于整个人工智能生态系统的测试,以便获得相关的资格认证。与此同时,美光已经在开发下一代的解决方案,包括HBM4和HBM4E,继续突破DRAM性能界限,确保美光的产品可以满足AI芯片对日益增长的内存性能需求,以保持行业领先地位。